软件介绍

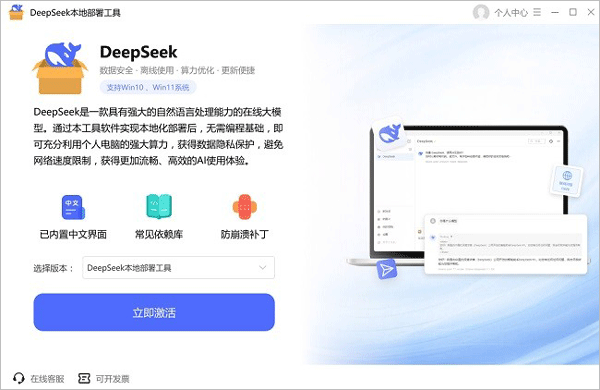

DeepSeek本地部署工具是一款专为个人开发者、企业用户及AI爱好者设计的高效解决方案,通过本地化运行DeepSeek大模型(如R1系列),实现对数据隐私、计算效率与个性化需求的全面掌控。作为由杭州深度求索人工智能基础技术研究有限公司推出的高性能语言模型,DeepSeek凭借其“深度学习+探索能力”的双重优势,成为代码编写、文本生成、数据分析等领域的核心工具。而本地部署工具通过简化复杂的部署流程(如无需编写Docker配置、无需手动安装依赖库),让即使零经验的用户也能在几分钟内完成模型的加载与调试。通过集成Ollama平台与ChatBox可视化界面,用户可轻松实现模型调用、API接口开发及本地知识库构建,彻底告别云端服务的延迟与网络限制。

通过图形化界面或命令行工具,用户可快速下载并运行DeepSeekR1系列模型,支持1.5B、7B、32B版本灵活切换,无需手动配置环境变量或依赖库。

2.跨平台兼容性

完全适配Windows10+/macOS12+/Ubuntu20.04+系统,支持NVIDIA显卡(CUDA加速)与纯CPU运行模式,满足不同设备需求。

3.API接口开发支持

提供PythonAPI调用接口,用户可直接在本地代码中集成DeepSeek模型,用于自然语言处理、文本摘要、代码生成等任务。

4.可视化交互界面

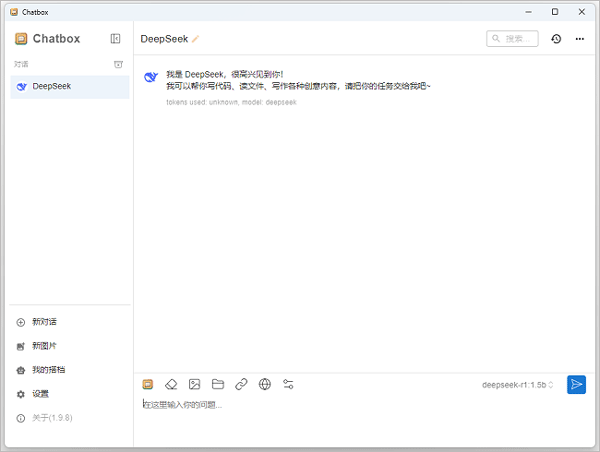

集成ChatBox客户端,支持多轮对话、上下文记忆、文件上传分析等功能,提升用户体验并降低技术门槛。

5.私有化知识库构建

结合AnythingLLM等工具,用户可将企业文档、专利资料、行业报告等私有数据导入模型,打造专属问答系统与智能助手。

6.资源优化与性能监控

实时显示GPU/内存占用情况,支持动态调整模型参数(如batch_size、max_seq_length),平衡性能与硬件负载。

7.混合部署模式

支持本地模型与云端服务联动,例如将高频查询任务分配至本地,复杂推理交由云端处理,实现资源利用最大化。

无需编写代码或理解Docker容器技术,用户通过点击按钮即可完成从模型下载到服务启动的全流程。

2.硬件友好型设计

提供分层模型版本(1.5B仅需4GB显存,7B适配8GB显存设备),兼顾低配设备运行与高性能场景需求。

3.数据隐私保障

所有数据处理均在本地完成,杜绝云端泄露风险,尤其适合金融、医疗、法律等对合规性要求严苛的行业。

4.生态扩展能力

支持与VSCode、JupyterNotebook、RooCODE等开发工具深度集成,打造“AI+编程”高效工作流。

5.持续更新与社区支持

官方定期发布模型优化版本(如2025年新增4K上下文支持),并通过GitHub开源项目提供技术文档与用户答疑。

6.断网运行能力

一旦部署完成,模型可脱离网络独立运行,适用于网络不稳定或完全隔离的生产环境。

回答:1.5B版本最低需4GB显存+核显,7B版本推荐8GB显存+NVIDIAGTX1060以上显卡,32B版本需32GB显存+专业显卡。

2.“部署失败提示‘CUDA未初始化’怎么办?”

回答:检查CUDA驱动是否安装,或在Ollama配置文件中将device参数从“cuda”改为“cpu”强制使用CPU运行。

3.“如何升级模型版本?”

回答:在Ollama命令行输入ollamapulldeepseek-r1:7b下载新版本,或通过ChatBox界面直接更新。

4.“模型运行时卡顿或报错?”

回答:尝试降低batch_size参数,关闭其他占用资源的程序,或升级显卡驱动。

5.“能否将本地模型用于商业用途?”

回答:需遵守DeepSeek的开源协议(如Apache2.0),商用前建议咨询官方获取授权。

DeepSeek电脑端部署工具使用说明

1、下载完成后,双击运行安装包,点击“立即激活”;

2、激活成功后,根据电脑配置情况选择合适的模型,不同模型占用的内存大小不同;

注意:可选择“推荐”模型

3、自定义安装路径,设置好后直接点击下载;

4、下载安装过程中,请耐心等候;

5、模型下载安装成功后,点击“立即体验”;

6、此时,就可以运行并使用DeepDeek了。

DeepSeek电脑端部署工具功能

1.一键式模型部署通过图形化界面或命令行工具,用户可快速下载并运行DeepSeekR1系列模型,支持1.5B、7B、32B版本灵活切换,无需手动配置环境变量或依赖库。

2.跨平台兼容性

完全适配Windows10+/macOS12+/Ubuntu20.04+系统,支持NVIDIA显卡(CUDA加速)与纯CPU运行模式,满足不同设备需求。

3.API接口开发支持

提供PythonAPI调用接口,用户可直接在本地代码中集成DeepSeek模型,用于自然语言处理、文本摘要、代码生成等任务。

4.可视化交互界面

集成ChatBox客户端,支持多轮对话、上下文记忆、文件上传分析等功能,提升用户体验并降低技术门槛。

5.私有化知识库构建

结合AnythingLLM等工具,用户可将企业文档、专利资料、行业报告等私有数据导入模型,打造专属问答系统与智能助手。

6.资源优化与性能监控

实时显示GPU/内存占用情况,支持动态调整模型参数(如batch_size、max_seq_length),平衡性能与硬件负载。

7.混合部署模式

支持本地模型与云端服务联动,例如将高频查询任务分配至本地,复杂推理交由云端处理,实现资源利用最大化。

DeepSeek电脑端部署工具特点

1.极简操作体验无需编写代码或理解Docker容器技术,用户通过点击按钮即可完成从模型下载到服务启动的全流程。

2.硬件友好型设计

提供分层模型版本(1.5B仅需4GB显存,7B适配8GB显存设备),兼顾低配设备运行与高性能场景需求。

3.数据隐私保障

所有数据处理均在本地完成,杜绝云端泄露风险,尤其适合金融、医疗、法律等对合规性要求严苛的行业。

4.生态扩展能力

支持与VSCode、JupyterNotebook、RooCODE等开发工具深度集成,打造“AI+编程”高效工作流。

5.持续更新与社区支持

官方定期发布模型优化版本(如2025年新增4K上下文支持),并通过GitHub开源项目提供技术文档与用户答疑。

6.断网运行能力

一旦部署完成,模型可脱离网络独立运行,适用于网络不稳定或完全隔离的生产环境。

常见问题

1.“我的电脑配置能否运行DeepSeek?”回答:1.5B版本最低需4GB显存+核显,7B版本推荐8GB显存+NVIDIAGTX1060以上显卡,32B版本需32GB显存+专业显卡。

2.“部署失败提示‘CUDA未初始化’怎么办?”

回答:检查CUDA驱动是否安装,或在Ollama配置文件中将device参数从“cuda”改为“cpu”强制使用CPU运行。

3.“如何升级模型版本?”

回答:在Ollama命令行输入ollamapulldeepseek-r1:7b下载新版本,或通过ChatBox界面直接更新。

4.“模型运行时卡顿或报错?”

回答:尝试降低batch_size参数,关闭其他占用资源的程序,或升级显卡驱动。

5.“能否将本地模型用于商业用途?”

回答:需遵守DeepSeek的开源协议(如Apache2.0),商用前建议咨询官方获取授权。

相关文章